Возможно, самым пугающим аспектом искусственного интеллекта является его способность генерировать глубоко поддельные изображения.

Конечно, некоторые вызывают смех. Лицо Арнольда Шварценеггера наложилось на “Грязного Гарри” Клинта Иствуда, направляющего оружие на убегающего подозреваемого. Майк Тайсон превратился в Опру. Дональд Трамп превратился в Боба Оденкирка из “Лучше позвони Солу”. Николас Кейдж в роли Лоис Лейн в фильме “Супермен”.

Но последние события предвещают более тревожную тенденцию, поскольку цифровая подделка становится вредоносной.

Буквально на прошлой неделе актер Том Хэнкс выступил в социальных сетях с осуждением рекламы, в которой его изображение, созданное искусственным интеллектом, использовалось для продвижения плана стоматологического лечения. Популярному ютуберу Mr. Beast, который может похвастаться более чем 50 миллиардами просмотров своих видео с 2012 года, было ложно показано, что он предлагает iPhone 15 Pros за 2 доллара.

Обычные граждане тоже становятся мишенями. Лица людей появляются на изображениях в социальных сетях без их согласия. Наиболее тревожным является рост числа случаев “порно мести”, в котором брошенные любовники публикуют сфабрикованные изображения своих бывших партнеров в компрометирующих или непристойных позах.

И поскольку политически разделенные Соединенные Штаты осторожно приближаются к крайне спорной битве за президентство в 2024 году, перспектива использования поддельных изображений и видеозаписей обещает беспрецедентно уродливые выборы.

Кроме того, распространение поддельных изображений перевернет с ног на голову правовую систему в том виде, в каком мы ее знаем. Как недавно сообщило национальное некоммерческое СМИ NPR, юристы извлекают выгоду из незадачливой публики, иногда сбитой с толку тем, что является правдой, а что ложью, и все чаще оспаривают доказательства, представленные в суде.

Хани Фарид, специализирующаяся на анализе цифровых изображений в Калифорнийском университете в Беркли, сказала: “Это именно то, что нас беспокоило: когда мы вступили в век глубоких подделок, любой может отрицать реальность”.

“Это классический дивиденд лжеца”, – сказал он, имея в виду термин, впервые использованный в 2018 году в отчете о потенциальном посягательстве deepfake на частную жизнь и демократию.

Крупнейшие цифровые медиа—компании – OpenAI, Alphabet, Amazon, DeepMind — пообещали разработать инструменты для борьбы с дезинформацией. Одним из ключевых подходов является использование водяных знаков на контенте, созданном искусственным интеллектом.

Но статья, опубликованная 29 сентября на сервере препринтов arXiv, содержит тревожные новости о возможности пресечения такого цифрового злоупотребления.

Профессора Мэрилендского университета провели тесты, демонстрирующие легкость обхода защитных водяных знаков.

“На данный момент у нас нет надежных водяных знаков”, – сказал Сохейл Фейзи, один из авторов отчета “Надежность детекторов изображений с искусственным интеллектом: фундаментальные ограничения и практические атаки”.

Фейзи сказал, что его команда “сломала их всех”.

“Неправильное применение искусственного интеллекта создает потенциальные опасности, связанные с дезинформацией, мошенничеством и даже проблемами национальной безопасности, такими как манипулирование выборами”, – предупредил Фейзи. “Глубокие подделки могут привести к личному ущербу, начиная от дискредитации персонажа и заканчивая эмоциональным расстройством, воздействуя как на отдельных людей, так и на общество в целом. Следовательно, идентификация контента, созданного с помощью искусственного интеллекта… становится важнейшей задачей, требующей решения”.

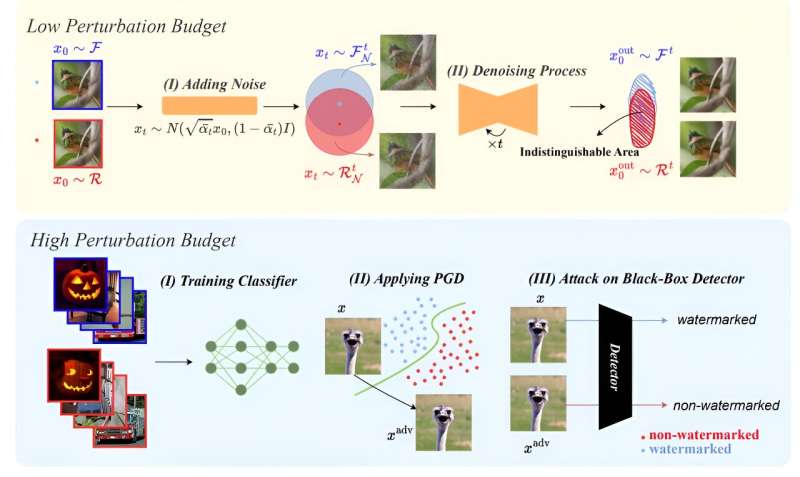

Команда использовала процесс, называемый диффузионной очисткой, который применяет гауссовский шум к водяному знаку, а затем удаляет его. Это оставляет искаженный водяной знак, который может обойти алгоритмы обнаружения. Остальная часть изображения изменена лишь минимально.

Кроме того, они успешно продемонстрировали, что злоумышленники, имеющие доступ к алгоритмам создания водяных знаков “черного ящика”, могут подсовывать поддельные фотографии с маркировкой, которая обманным путем заставляет детекторы поверить, что они являются законными.

Несомненно, появятся более совершенные алгоритмы. Как и в случае с вирусными атаками, плохие парни всегда будут работать над тем, чтобы сломать любую защиту, которую придумают хорошие парни, и игра в кошки-мышки будет продолжаться.

Но Фейзи выразил некоторый оптимизм.

“Основываясь на наших результатах, разработка надежного водяного знака является сложной, но не обязательно невыполнимой задачей”, – сказал он.

На данный момент люди должны проявлять должную осмотрительность при просмотре изображений, содержащих контент, который может быть важен для них. Необходимы бдительность, перепроверка источников и хорошая доза здравого смысла.